高通发布第二代骁龙XR2和第一代骁龙AR1,能否再次革新产业格局?

文/VR陀螺

在Meta Connect 2023大会上,伴随着Meta Quest 3和Meta与雷朋联合打造的Ray-Ban Meta智能眼镜正式亮相,高通也正式发布了最新的骁龙XR专用平台:第二代骁龙XR2和第一代骁龙AR1。这两款平台也借由Meta的硬件新品实现商业化落地,正式走向消费者。

芯片作为XR设备的核心,相关技术飞速发展,如今XR设备已不再需要依赖手机处理器。面向虚拟现实(VR)、混合现实(MR)和增强现实(AR)三大领域,高通现已拥有完整的XR专用平台产品组合。

自2018年高通发布首款XR专用平台第一代骁龙XR1以来,陆续推出第一代骁龙XR2、第一代骁龙XR2+、第一代骁龙AR2平台,获得了全球多家XR品牌的认可,目前已有80+款XR设备采用了骁龙平台。第二代骁龙XR2和第一代骁龙AR1的问世,将会对行业带来哪些影响?本文将探究高通在XR领域的最新布局。

第二代骁龙XR2功能性升级:能效、交互、显示、AI、连接

第二代骁龙XR2是高通进一步推动VR/MR设备普及而打造的全新XR专用平台,尤其为MR部分提供了更加稳定的技术支撑。

Quest 3在发布之前,行业内已流传了不少曝光信息,随着设备的正式发布,才得以一窥高通在其中发挥的底层技术实力。Quest 3售价499美元,现已接受预定,于10月10日发售。(详细内容可参照VR陀螺文章:《混合现实+AI+智能眼镜!Meta Connect大会打出组合拳》)

1、游戏性能加倍:GPU性能提升2.5倍,功耗降低50%

在能效和性能方面,根据高通官方提供的相关参数,第二代骁龙XR2针对单芯片架构进行了大幅优化,其与第一代骁龙XR2相比,GPU性能提升了2.5倍,GPU能效提升了50%,相当于延长VR/MR设备电池续航时间,且不再需要外置电池组,以便帮助OEM厂商打造高性能且价格合理的设备。

在显示方面,第二代骁龙XR2可支持3K×3K显示,游戏超级分辨率、视觉聚焦渲染、空间扭曲。此处提到三项技术均与游戏显示性能优化有关:

- 骁龙游戏超级分辨率,是一项单一通道空间感知超分技术,实现高性能、高质量、低功耗。能够将1080P的游戏画质提升至4K水准,30FPS的画面更是能够呈现出60FPS的效果。

- 视觉聚焦渲染,结合摄像头和传感器数据,该技术可支持眼球追踪和虹膜认证,对用户注视的内容进行工作负载优化,以帮助降低功耗。

- 空间扭曲,可以即时补充缺失帧以提高画面帧率以及流畅性,即便用户的设备性能较低,也可以通过该技术降低渲染的计算量,并获得较高的分辨率。

Meta Connect会上还以即将发售的《阿斯加德之怒2》为例,展示了Quest 3一体机以第二代骁龙XR2为支撑的强大游戏性能。

以上技术能进一步提升VR/MR内容的色彩和细节,在保持同样的视觉效果的情况下降低功耗,这对开发者来说无疑是一大利好消息。

2、VST视频透视线程优化,时延降至12ms

高通认为,从能够实现完全沉浸式和数字化的虚拟现实,到物理世界和数字世界无缝融合的混合现实,以及能够在物理空间中叠加虚拟内容的增强现实。这三大XR场景应该是相互连通的,但以现有的XR设备如何让人从感官上获取更真实的虚实融合体验,MR或许是最好的方法。

如果要在VR/MR头显中体验虚实融合的内容,主要依托VST技术将头显摄像头拍摄到的画面实时传输到屏幕上。

早期的VST主要使用单色摄像头,完成空间定位和物理识别,主要用于安全边界定位和手部追踪,如今在MR领域得到了更出彩的应用,例如刚发布的Quest 3,已发布的Quest Pro、PICO 4,以及未上市的苹果Vision Pro均搭载了全彩摄像头,以尽可能地将现实世界的全貌反映到头显屏幕中。

从Meta的演示来看,Quest 3的高保真全彩Passthrough可以让用户的物理环境清晰可见,效果更佳,与前代产品不同,Quest 3支持房间扫描,可自动创建安全边界。Meta还表示,Quest 3的像素比Quest 2高出10倍以上。

高通优化了整个视频透视线程,第二代骁龙XR2可以实现低至12ms的视频透视时延。另外,还将通过几何校正、降噪、动态亮度调整等技术,提升视频透视的图像质量。

3、感知交互精细度提升,AI引擎性能提升8倍

在交互方面,高通将并发感知技术分为两个部分,一是环境理解,二是用户理解。

要实现MR效果,环境理解算法是关键。第二代骁龙XR2最高支持10路并发摄像头和传感器,可准确地完成平面检测、深度估计、3D重建、语义理解、物体识别和追踪,定位墙壁、家具以及其他物品的现实位置。由此开发者可以将虚拟内容放置在用户当前的现实场景,例如用户在MR场景中抛出一个虚拟球,球的运动轨迹能与现实场景进行相应的物理碰撞反馈。

针对用户理解,第二代骁龙XR2能够同时处理用户头部追踪、眼球追踪、面部表情、手势追踪的运动输入数据,同时对全身运动的感知能力也扩展了手柄追踪、动作追踪的精细程度,甚至支持虚拟形象的编/解码。

Quest 3还官宣了明年将推出的“Augments”新功能,这是一种能够识别空间的交互式虚拟对象,它可固定于现实环境中。如用户可以在墙上挂上包含Facebook和Instagram照片/视频的电子相框等。

但要做到实时检测空间,锚定虚拟3D内容并长期存储,将产生十分庞大的数据量,同时需要消耗大量算力,为此高通提升了XR平台所搭载的高通AI引擎能力,每瓦特性能可提升8倍。

在高通AI引擎方面,第二代骁龙XR2支持INT8,大大提高了运算效率,同时优化了不同AI模块之间的连接,以实现紧密的协同处理。高通还针对计算机视觉模块做了改进,为第二代骁龙XR2打造了专用模块视觉分析引擎(Engine for Visual Analytics),其中的“Feature detection and tracking”(特征探测和追踪),这项功能会直接在硬件上运行,大幅提升6DoF追踪效果。

具体来说,在第一代骁龙XR2中是通过软件实时运作来实现特征探测和追踪,而在第二代骁龙XR2,这项功能则是在芯片层面通过视觉分析引擎实现,关键点检测数量将大幅提升,功耗和时延降低。随着训练AI模型的参数逐步增加,对内存容量的挑战难度在增大,高通也一并扩展了终端侧的内存。

4、支持Wi-Fi 7 / Wi-Fi 6E,实现无界XR连接

在连接传输方面,高通在通讯领域的技术积累也在XR中的流畅交互得以体现。

VR/MR设备的数据传输需要保持始终在线的状态,而且还要满足与游戏PC相连的需求, 第二代骁龙XR2支持新一代的Wi-Fi 7和Wi-Fi 6E技术,对用户体验有着极大改善,对设备之间互联互通、XR内容传输、手机无线连接、实时多频互动、高速上传下载等应用场景带来了直观的效率和稳定性提升。

高通面向XR推出的高通FastConnect软件套件也融合到了第二代骁龙XR2中,使Wi-Fi连接功耗降低25%,峰值速度可达5.8Gbps,时延降低80%。通过FastConnect软件套件的支持,还可让用户“即连即用”,保证在使用XR设备时的稳定性,也能在VR/MR场景中改善时延、抖动性等问题。

第一代骁龙AR1:眼镜侧AI辅助日常使用“解放双手”

高通近年来在AR方面持续投入,三年内陆续推出两款AR眼镜参考设计以及AR专用平台第一代骁龙AR2,并构想了理想化的AR智能眼镜的多个特性:分布式处理、轻便日常、无线连接、智能交互等等。

现在,搭载第一代骁龙AR1的Ray-Ban Meta智能眼镜已正式发布,对于这类智能眼镜,扎克伯格表示:“我认为智能眼镜将成为未来的一个重要平台......之前团队不少人认为智能眼镜只有真正实现3D全息图、内置显示器等才会真正普及,但是这需要很长的时间。如今得益于AI的进步,内置的AI助手将能看到你所看到的,听到你所听到的,AI将与其他AR功能同样重要。”

第一代骁龙AR1将着重围绕日常生活中的场景带来沉浸式互动体验支持,主要集中在以下几点:即时拍摄、AI能力、可拓展平台、虚拟助手、视觉搜索等。

1、解放双手、快速连接,即时拍摄改变智能眼镜影像记录方式

第一代骁龙AR1通过拍摄、眼镜侧AI等功能来突出智能眼镜的“解放双手”能力,用户能直接与智能眼镜交互,降低智能眼镜对手机、电脑等终端的操作“依赖”。

例如拍摄方面,第一代骁龙AR1采用14-bit双ISP(图像信号处理器),14-bit ISP能够实现每秒捕捉27亿像素能力,能满足大部分拍摄需求,支持即时拍摄。且智能手机上常见的功能:自动曝光、自动人脸检测、计算HDR和人像模式,均可在骁龙AR1的智能眼镜中得以体验。

骁龙AR1有望改变智能眼镜拍摄照片和视频的方式,用户无需举起手机操作,只要抬手就能一键拍出高清照片和视频。FastConnect软件套件也在第一代骁龙AR1得以应用,且支持蓝牙5.2和5.3,实时视频直播、照片快速分享以及音乐串流功能均可实现。

2、眼镜侧AI:语音指令、视觉搜索,适用更多日常场景

AI能力在骁龙AR1同样发挥着重要作用,通过计算机视觉辅助提高拍摄照片/视频质量,支持AI辅助的回声消除和降噪,实现更清晰的语音通话。

骁龙AR1支持语音指令,可以通过AI将信息具现化,让用户在智能眼镜上看到结合现实情景的信息,随时启用视觉搜索、实时文本翻译以及导航功能,还集成健康传感器,可实时监测和追踪健康及运动数据。利用眼镜侧的AI能力,用户能够获得解放双手的完美虚拟助手,这在滑板、骑自行车、做饭等日常生活场景中十分有用。

3、支持AR单目/双目配置的可扩展平台

骁龙AR1是一款可扩展平台,支持三种不同配置,为OEM厂商带来更多选择:一是以拍摄和音乐功能为核心的智能眼镜;二是以通知提醒和导航功能为核心的单目显示智能眼镜;三是具有丰富的视觉效果和更多功能的双目显示智能眼镜。

Meta展示的Ray-Ban Meta智能眼镜,搭载骁龙AR1。整体外形轻巧精致时尚,与普通的墨镜并无太大差异,可满足全天候佩戴的需求,售价299美元,于10月17日发售。

此前有数据指出,初代Ray-Ban Stories共计销售了超过30万台,但是设备活跃度一般。可见人们对智能眼镜的需求并不低,将AI+AR结合起来,让智能眼镜渗透生活中的各个角落,便是高通为赋能下一代智能眼镜打造的首个专用平台骁龙AR1的目的。

解决XR普及路上“看得见”的技术难点:交互与显示

从游戏、社交、办公到企业应用,XR技术已渗透到工作生活等各大场景,作为沉浸式体验的重要硬件组成部分,XR设备能在显示和交互方面带来最直接的感官体验,相关技术的快速发展以及用户需求的多样化催生了更个性化的垂直场景探索。

尽管苹果强调的空间计算概念让更多人看到了XR的可能性和应用前景。但目前XR的普及度并不算高。对普通用户来说,更关注能通过XR看到什么内容,能在虚拟世界做什么。但画质不清晰、流畅度低、眩晕感、交互响应慢和定位不准确等这些“看得见”的显示和交互问题还未解决。

要实现理想化的XR显示和交互体验还有一段距离,高通作为XR底层供应链上的龙头企业,正积极布局XR专用芯片、AR专用芯片以及相关底层技术,并寻求与更多企业合作推动XR生态搭建来弥补物理世界和虚拟世界的差距。

目前高通已经有了明确的方向,随着XR对感知交互技术、高清显示、健康监测以及高速网络等功能的需求提升,AI的作用愈发凸显。AI的研发已成为主流趋势,高通也加大了在AI领域的投资,面向边缘终端推动混合AI规模化扩展。

有了AI在性能方面的优化支持,高通改善显示难点的第一步就是通过算法提升帧率,将游戏超级分辨率、视觉聚焦渲染、空间扭曲这些图像技术应用到XR平台,从而改善XR画面清晰度,提高显示质量和视觉效果。

另外,VST的显示效果也通过第二代骁龙XR2的几何校正、降噪、动态亮度调整等技术得到改进,全彩视频透视的图像质量得到提升的同时,时延降至12ms(一般来说,时延要在20ms以内才能有效缓解VR眩晕感)。

在XR领域,人机交互主要依靠各种输出/输入硬件和技术来实现:XR设备通过各种传感器和摄像头捕捉运动数据和空间数据,再将数据转化成代码并以此构建3D资产叠加到虚拟世界中。

相应的数据量也在成倍增大,对网络连接和感知技术来说是巨大的挑战。高通的第二步就是提升图像处理能力,第二代骁龙XR2的并发感知技术同时支持高达10路并行摄像头和传感器,相比上一代XR2平台(7路)可提供更加细致精确的运动追踪、面部追踪以及房间映射效果。

AR交互也是高通正在努力的方向,高通的骁龙AR1智能眼镜方案强调“所见即所得”拍摄能力的同时还强调了“解放双手”这一特性,除了减少在手机端的操作,将无界交互的语音指令、AI助手应用到更具体的场景,使其更加易用、常用。

凭借高通强大的集成能力,第二代骁龙XR2和第一大骁龙AR1两大平台,结合AI技术进一步提升了XR设备的性能、功耗、视觉效果、交互能力等,并率先成功应用到Quest 3和Ray-Ban智能眼镜。

空间计算仍在发展初期阶段,高通对现阶段的XR市场需求有着怎样的认知?

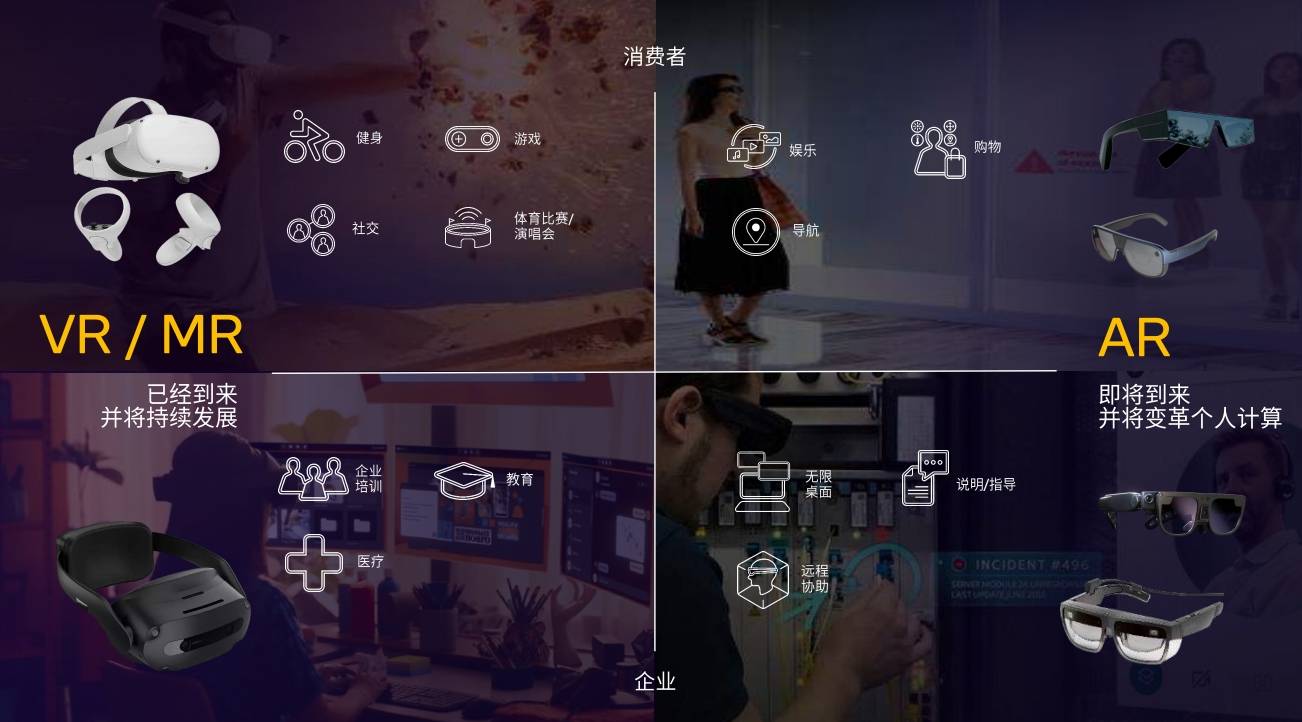

高通技术公司副总裁兼XR业务总经理司宏国(Hugo Swart)表示:“目前,VR和MR行业的发展势头非常强劲,游戏、健身、娱乐等消费级应用正在不断发展,此外在企业市场也出现了培训、教育、医疗等应用。在AR领域,面向消费者的沉浸式体验刚刚起步,但我们看到已经有大量的企业正在使用丰富的AR应用,包括远程协助、说明/指导、以及通过AR智能眼镜赋能的生产力工具。”

在沉浸式交互方面,实际上Meta在大会上展示的部分交互功能或与苹果Vision Pro有相似之处,高通是如何看待这两个不同的XR平台?

司宏国肯定了苹果对XR行业的积极作用,并表示:“高通和苹果的策略不同,他们产品的价格较为昂贵,并且需要采用多个芯片以及外置电池来支持。但是对于广大用户来说这可能并不是他们所期待的,而且这样的架构很难确保终端价格是大多数用户可以负担的。相似的手势识别和追踪功能,高通选择采用更加实用的思路,以将VR和MR体验带到更广阔的市场当中。”

在高清显示方面,为何高通仍主推3K×3K分辨率的解决方案,是否符合用户的体验和市场需求?

司宏国认为:“目前,4K显示仍然是非常昂贵的解决方案,还并不具备足以实现规模化扩展的供应能力。而3K×3K分辨率已经能够带来出色的视觉效果,相比市场上已有的解决方案有着很大的优势,我认为3K×3K能够在用户负担的起的价位上打造满意的用户体验,对于下一代VR/MR设备是最理想的选择。”

为什么之前推出了骁龙AR2,如今又“反向”推出骁龙AR1?

高通认为,实际上智能眼镜品类的发展潜力巨大。其外形可以像传统的墨镜一样轻巧时尚,可以全天佩戴,而且通过AI技术可实现更多智能化体验,还支持许多便捷功能,比如实时拍摄照片和视频,不需要再从口袋中掏出手机。

骁龙AR2采用多芯片架构,在AR眼镜上可以实现空间定位Slam(6DoF)等功能,这一平台的设计采用了分布式处理架构,支持将小部分工作负载直接在眼镜端进行处理,然后将大部分工作负载放在手机或其他主机终端上处理。

而新发布的骁龙AR1特别针对轻薄智能眼镜用例在影像拍摄、音乐串流等功能进行了优化,其支持的功能也相对简单,因此所有的处理可以在眼镜端完成,不需要借助手机。传输信息也只需要进行简单的Wi-Fi连接,使智能眼镜和智能手机相连即可。至此,高通的AR生态将更加丰满。

随着XR在技术方面的改进与发展,高通离自己期盼的XR未来越来越近,第二代骁龙XR2和第一代骁龙AR1有望加速空间计算的变革。